Du musst Cohen’s Kappa berechnen, aber hast (noch) keine Ahnung von Statistik und dein Gehirn schaltet sich ab, sobald du ein Formelzeichen siehst?

Dann bist du hier statistisch gesehen genau richtig.

Denn ich bin genau wie du. Ich bin auch der Meinung, mit Buchstaben sollte man nicht rechnen müssen. Aber wenn wir mit qualitativer Forschung punkten wollen, kann die Berechnung des Koeffizienten Cohen’s Kappa einen Nachweis über die Reliabilität Ergebnisse liefern. Und wenn Gutachterinnen oder die Verfasser qualitativer Methodenbücher das so möchten, dann machen wir das natürlich!

In diesem Artikel werde ich dich durch ein simples Beispiel führen, wie du per Hand und ohne jegliche Kenntnisse Cohen’s Kappa ausrechnen kannst. So verstehst du die Formel auf Anhieb und kannst die Berechnung sofort auch für dein Datenmaterial durchführen.

Inhaltsverzeichnis

Wozu sollte man überhaupt Cohen’s Kappa berechnen?

In einem Forschungsdesign, in welchem die menschliche Beurteilungskraft das Messinstrument darstellt, ist die Berechnung von Cohen’s Kappa eine Möglichkeit, die Reliabilität einer solchen Messung zu überprüfen.

Das kann wichtig sein, da womöglich die gesamten Forschungsergebnisse einer wissenschaftlichen Arbeit auf der Beurteilung einzelner Personen aufbauen. Dieser Personen sind die sogenannten Rater.

Ein solches Forschungsdesign kann in den verschiedensten Bereichen zum Tragen kommen, z.B. in der Medizin, wenn der Gesundheitszustand eines Menschen beurteilt werden soll, oder etwas weniger kritisch, in der empirischen Sozialforschung, wenn in einer Inhaltsanalyse Kategorien gebildet werden müssen.

Die Reliabilität der Beurteilung sagt nichts anderes aus, als dass das Vorgehen bzw. die Kriterien der Beurteilung zuverlässig sind, d.h. bei wiederholter Beurteilung, z.B. durch jemanden Drittes, könnte man das gleiche Ergebnis erwarten.

Eine ausführliche Erklären zur Reilibilität findest du auch in meinem Artikel: Reliabilität, Validität und Objektivität – Die 3 Gütekriterien einfach erklärt.

Im Allgemeinen kann hier zwischen zwei Varianten der Reliabilität unterschieden werden.

Interrater-Reliabilität

Diese kommt zum Tragen, wenn zwei oder mehr Rater das Datenmaterial beurteilen. Die Relibilität, z.B. in Form von Cohen’s Kappa sagt dann aus, wie sehr die Beurteilungen der einzelnen Rater übereinstimmen. Das ist wie gesagt ein wichtiges Signal für die Zuverlässigkeit der Methodik.

Intra-Rater Reliabilität

In vielen Fällen, z.B. einer studentischen Abschlussarbeit, ist jedoch nur ein Rater zugegen. Hier kann überprüft werden, wie konsistent die Person darin ist, ihre Beurteilungen nach gleichen Kriterien zu treffen. Die Berechnung dieser Reliabilität kann außerdem hilfreich sein, wenn ein und dieselbe Person laut des Forschungsdesigns zu verschiedenen Zeitpunkten einen Sachverhalt beurteilen muss.

Zur Berechnung dieser Reliabität wird in der Wissenschaft nun eben sehr häufig Cohen’s Kappa verwendet, ein statistischer Koeffizient. Das hört sich schlimmer an als es ist. Denn die Berechnung kriege sogar ich auf die Reihe. Und wenn ich das kann, kannst du das auch.

Cohen’s Kappa berechnen

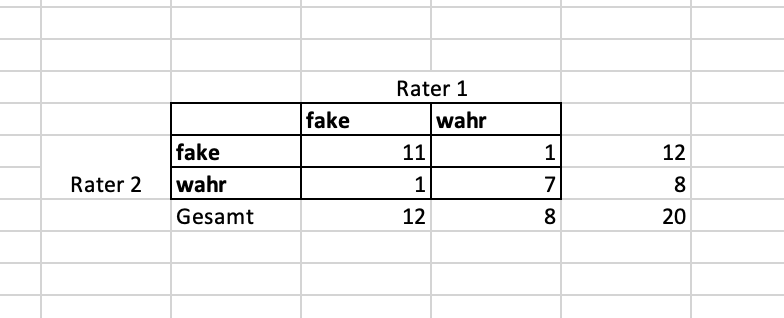

Die Grundlage für die Berechnung ist eine ganz einfache Matrix.

In dieser Matrix siehst du die beiden Rater ganz außen. Diese können jeden Fall jeweils mit A oder B beurteilen (z.B. krank/gesund; positiv/negativ; Kategorie A/Kategorie B usw.).

In der Zelle a wird nun eingetragen, wie oft beide Rater den gleichen Fall mit Zustand A beurteilt haben (z.B. krank/krank; positiv/positiv; Kategorie A/Kategorie A).

Die Zelle d zeigt, wie oft beide Rater den gleichen Fall mit Zustand B beurteilt haben (z.B. gesund/gesund; negativ/negativ; Kategorie B/Kategorie B).

In der Zelle b und c wird entsprechend eingetragen, in wie vielen Fällen die beiden Rater voneinander abweichen (z.B. gesund/krank; positiv/negativ; Kategorie A/Kategorie B).

Bevor du dich nun an die Formel von Cohen’s Kappa wagen kannst, musst du noch die Summen bilden und einfach alle Zeilen und Spalten zusammen addieren. Wenn unten rechts die Gesamtzahl deiner Fälle (N) herauskommt, hast du alles richtig gemacht.

Fake News auf Facebook (Beispiel zum Cohen’s Kappa berechnen)

Damit wir das ganze einmal mit echten Zahlen durchspielen können, schauen wir uns ein Beispiel an.

Nehmen wir an, zwei Personen schreiben an einer Studie, in der Fake News auf Facebook analysiert werden sollen. Dazu wurden 20 News-Postings gesammelt, die zunächst nun auf ihren Wahrheitsgehalt hin beurteilt werden müssen. Beide Rater nehmen sich die Postings vor und bestimmen ob der Artikel als fake oder als wahr zu klassifizieren ist.

Die Beurteilungen werden nun in einer Tabelle gesammelt.

Die Ergebnisse können nun in die Übereinstimmung-Matrix übertragen werden. Das sieht dann so aus:

Ab jetzt folgt der Teil, in dem du ein wenig rechnen musst – ist aber alles halb so wild.

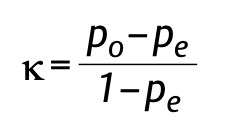

Die Formel zum Cohen’s Kappa berechnen sieht so aus:

Um auf das Kappa zu kommen, brauchst du jetzt also noch zwei Werte: P0 und Pe.

Der erste Wert den du berechnen musst, ist das Maß an Übereinstimmung relativ zur Gesamtzahl (P0). Diese Größe wird so berechnet Po = (a+d)/N; also alle Fälle in denen beide Rater übereinstimmen, geteilt durch die Gesamtzahl aller Fälle (N).

In unserem Beispiel wäre das P0 = (11+7)/20 = 0,9. P0 ist also 0,9.

Da es in der Realität aber dazu kommen kann, dass beide Rater einfach zufällig übereinstimmen, reicht das zur Bestimmung der Reliabilität nicht aus. Dieser Zufall muss herausgerechnet werden, und zwar mit dieser Formel:

Pe= ((a+b)/N*(a+c)/N)+((c+d)/N*(b+d)/N)

Das sieht schon gruselig aus, ist aber nicht einfach er darzustellen. Du kannst dich dabei einfach eng an der Formel halten und die Werte aus deiner Tabelle eintragen. Denke daran, dass bei der Berechnung die inneren Klammern zuerst dran sind.

Für unser Beispiel wäre das also Pe = ((11+1)/20*(11+1)/20)+((1+7)/20*(1+7)/20). Im nächsten Schritt bliebe dann (0,6*0,6)+(0,4*0,4) und dann 0,36 + 0,16 = 0,52.

Jetzt setzen wir Po und Pe in die große Formel ein.

K=0,9-0,52/1-0,52 macht gleich 0,38/0,48 = 0,79

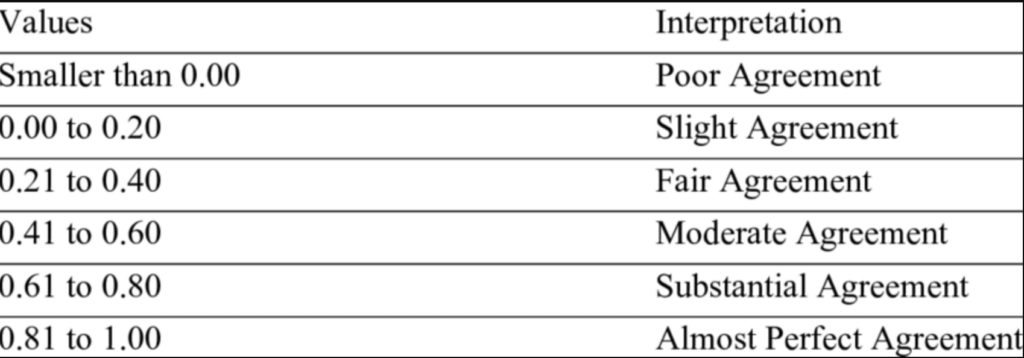

Cohen’s Kappa ist in unserem Beispiel also 0,79. Aha. Cool. Glücklicherweise gibt es nun eine Tabelle, anhand der wir das Ergebnis interpretieren können.

Unsere Übereinstimmung ist also am oberen Rand des „Substantial Agreements“, also fast „fast perfect“. 1.0 wäre übrigens perfekt. Alles was über 0.61 liegt, kannst du also als zufriedenstellend einordnen. Darunter müsstest du überdenken, die Kriterien zur Messung bzw. Beurteilung zu überarbeiten.

Wenn du überlegst, dass die beiden Rater in unserem Beispiel in 2 von 20 Fällen nicht übereinstimmen (also 10%), macht der Wert von 0,79 ja durchaus Sinn.

Ein höheres Agreement lässt sich erreichen, indem beide Rater sich immer wieder zusammensetzten und über die Kriterien diskutieren. Das ist aber nur nötig, wenn der Wert wirklich zu niedrig ist. Bei 0,79 müsste man nicht versuchen, diesen Wert noch weiter zu verbessern.

Je nach dem wie sich der Wert für deine Arbeit entwickelt oder auch sofort zufriedenstellen ist – so berichtest du dann den Wert in deinem Methodenkapitel. Hier reicht es, nur den Wert anzugeben. Bitte keine Rechenschritte.

Damit du all diese Rechenschritte nicht per Hand wie in diesem Tutorial machen musst, kannst du ganz einfach ein Online Tool verwenden, z.B. dieses hier: Online-Rechner für Cohen’s Kappa

Natürlich kann jede handelsübliche Statistik-Software wie SPSS oder R Cohen’s Kappa ebenfalls mit wenigen Klicks ausrechnen. Da für qualitative Daten so eine Software aber oft gar nicht nötig ist, reicht auch der Online-Rechner.

Hol‘ dir jetzt die Komplettlösung zum Verfassen einer herausragenden Hausarbeit:

Cohen’s Kappa berechnen (mehr als 2 Rater oder Kategorien)

Hast du in deiner Datensammlung mehr als nur zwei Kategorien, dann funktioniert Cohen’s Kappa immer noch. Die Matrix würde dann einfach um weitere Zeilen bzw. Spalten erweitert und demnach auch die Rechenschritte. Bei dem Online-Rechner, den ich dir verlinkt habe, kannst du das ganz bequem einstellen.

Hast du jedoch einen Fall, bei dem mehr als zwei Rater die Daten beurteilen, musst du auf eine Erweiterung von Cohen’s Kappe zurückgreifen, nämlich Fleiss‘ Kappa. Aber für heute haben wir nun wirklich genug gerechnet.

Wenn du jetzt auf dem Weg zu mehr Erfolg im Studium noch ein wenig Starthilfe für deine wissenschaftliche Arbeit benötigst, dann habe noch ein PDF für dich, das du dir gratis herunterladen kannst:

Die 30 besten Formulierungen für eine aufsehenerregende Einleitung

2 Gedanken zu „Cohen’s Kappa berechnen (Interrater-Reliabilität einfach erklärt)“

Hi,

danke für die Seite und die Informationen.

Wie berechnet sich Cohens Kappa bei nur einem Rater?

Beispielsweise bei einer Masterarbeit mit Qualitativer Inhaltsanalyse und der Auswertung mit X Interviews?

Kannst du dazu ein Beispiel machen?

Danke und viele Grüße

René